Le robots.txt est un fichier qui fournit des instructions aux robots d’exploration des moteurs de recherche. Ce fichier permet notamment de refuser l’accès à certaines pages pour tous les agents ou pour une liste d’agents que vous avez préalablement identifiés. Aussi appelé protocole d’exclusion des robots, le robots.txt est un fichier essentiel à créer et à placer à la racine de votre site.

Inventés en 1994 par Martijn Koster, les robots.txt sont rapidement devenus la norme en matière d’exploration des sites web par les moteurs de recherche.

Pourquoi utiliser un robots.txt ?

Un robots.txt informe les robots d’exploration d’un moteur de recherche des URL auxquelles ils peuvent accéder. Il est dans votre intérêt de créer un tel fichier, car il permet de réduire le nombre de requêtes effectuées par les robots. Ils se concentreront sur l’exploration des pages répertoriées dans votre robots.txt, alors n’oubliez pas d’indiquer votre sitemap.

Le robots.txt fournit des règles à suivre aux robots qui explorent votre site internet. Cependant, ce fichier ne peut pas les contraindre. Ainsi, s’il arrive que des robots malveillants tentent de chercher des failles ou d’attaquer votre contenu, le fichier ne vous protège pas. Vous n’avez pas à vous inquiéter à propos des robots des moteurs de recherche, car ils respectent les règles.

Il est important de rappeler qu’un robots.txt ne permet pas d’empêcher l’indexation de vos pages. Si vous souhaitez empêcher l’indexation, vous devez ajouter la balise meta noindex à votre page, comme suit :

<meta name="robots" content="noindex">L’utilisation d’un fichier robots.txt n’est pas obligatoire. En effet, si vous souhaitez que l’ensemble de votre contenu soit référencé, l’utilisation de ce fichier ne sert à rien. Cependant, si vous visez un bon référencement naturel (SEO), l’utilisation d’un tel fichier permet d’économiser le budget de crawl, c’est-à-dire le nombre de pages que les robots d’exploration sont autorisés à explorer. Cela vous permet de concentrer l’exploration des robots sur vos pages ou articles à forte valeur ajoutée et d’éviter de disperser leur attention sur des contenus de qualité moyenne.

Créer un robots.txt avec un plugin

WordPress facilite la création de sites web pour tous, même sans compétences techniques. Les plugins sont le meilleur moyen d’obtenir des solutions à vos problèmes. Cependant, nous ne vous conseillons pas spécifiquement d’utiliser un plugin pour cette tâche. C’est pourquoi nous allons vous recommander un plugin qui ne se limite pas à cette fonction.

Le plugin Yoast Seo

Yoast SEO est un plugin très populaire sur WordPress qui permet d’ajouter des balises meta à vos pages et articles, tout en vous donnant accès à quelques méthodes et outils pour améliorer votre référencement naturel. Ce plugin offre également la possibilité d’ajouter ou de modifier votre fichier robots.txt. Pour ce faire, rendez-vous sur votre site web, puis accédez à Yoast SEO, Outils, et Éditeur de fichiers. Dans cette section, vous pouvez créer ou modifier votre fichier.

Comment créer un robots.txt sans plugin sur WordPress ?

Il est également possible d’ajouter votre fichier robots.txt directement à la racine de votre installation, soit par votre prestataire d’hébergement, soit via un client FTP comme FileZilla. Voici comment le faire avec Hostinger, qui facilite cette opération :

Procédure avec Hostinger

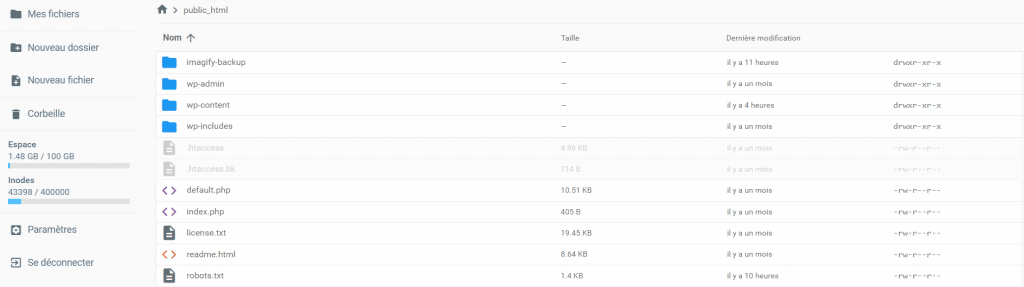

Dans votre tableau de bord Hostinger, rendez-vous dans la section Fichiers et cliquez sur Gestionnaire de fichiers (bêta), vous pouvez également vous rendre dans Gestionnaire de fichiers.

Vous êtes maintenant à la racine de votre site, vous pouvez dès lors créer un fichier, avec un clic droit, ou bien en passant par le bouton dans la colonne de gauche intitulé « Nouveau fichier », il est essentiel de le nommer comme suit : robots.txt pour que tout fonctionne correctement.

Procédure avec FileZilla

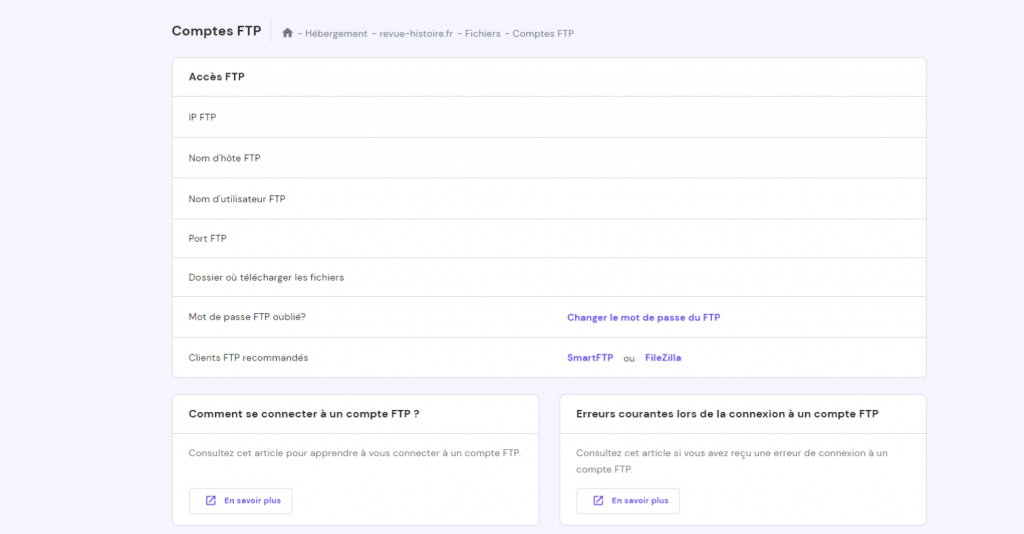

Ce logiciel est un client FTP, FTPS et SFTP, vous pouvez vous connecter à votre site web grâce aux informations qui vous ont été transmises durant la création de celui-ci, ou via votre tableau de bord. Sur Hostinger ces informations sont disponibles dans la section Fichiers de votre tableau de bord.

Une fois connecté, la procédure est la même que pour Hostinger. Vous devez créer votre fichier robots.txt puis y ajouter du contenu.

Que dois-je ajouter dans mon fichier robots.txt ?

Le contenu de votre fichier est relativement simple, nous vous offrons la possibilité de découvrir notre configuration du robots.txt, mais aussi de le réaliser vous-même avec les informations qui suivent.

Les règles élémentaires du robots.txt :

1 - User-agent: Googlebot

2 - Disallow: /nogooglebot/

3 -

4 - User-agent: *

5 - Allow: /

6 -

7 - Sitemap: http://www.example.com/sitemap.xmlLa première ligne permet de parler exclusivement au Googlebot. La seconde ligne interdit l’accès à l’URL /nogooglebot/ au Googlebot. La quatrième et cinquième lignes permettent d’autoriser tous les robots d’accéder au site. La septième ligne permet de faciliter l’accès à votre sitemap.